Skyhawk Security 对 LLM 网络威胁预测的准确性进行排名 在线

新的生成性AI基准评估大语言模型在网络安全中的应用

关键要点

云安全供应商Skyhawk推出了一项新基准,评估生成性AI大型语言模型LLMs在识别和评分网络安全威胁方面的能力。该基准测试了如ChatGPT、谷歌BARD、Anthropic Claude等模型在处理云日志和遥测数据中的表现。使用生成性AI可显著提升安全漏洞的扫描和过滤能力。在评估过程中,Skyhawk用精度、召回率和F1分数三种方式衡量LLMs的预测能力。云安全供应商Skyhawk最近推出了一项评估生成性 AI 大型语言模型LLMs在识别和打分网络安全威胁方面能力的新基准。该免费的资源分析了包括ChatGPT、Google BARD和Anthropic Claude在内的模型在预测攻击序列的恶意性时的表现,根据该公司的描述。生成性AI聊天机器人和LLMs在风险方面可以是把双刃剑,但如果正确使用,它们可以在许多方面提高组织的网络安全性。其中之一是它们能够比人类安全分析师更快、更高效地识别和剖析潜在的安全威胁。

根据云安全联盟CSA报告显示,生成性AI模型能够显著增强安全漏洞的扫描和过滤。报告中表明,OpenAI 的 Codex API 是一种有效的编程语言如C、C#、Java和JavaScript的漏洞扫描器。“我们可以预见,像Codex家族这样的LLMs将成为未来漏洞扫描器的标准组件,”报告中写道。例如,可以开发一种扫描器来检测和标记不同语言中的不安全代码模式,帮助开发者在潜在漏洞变成严重安全风险之前加以解决。报告还发现生成性AI/LLMs具备显著的威胁过滤能力,为那些可能被人类安全人员漏掉的威胁标识符提供解释和宝贵的背景信息。

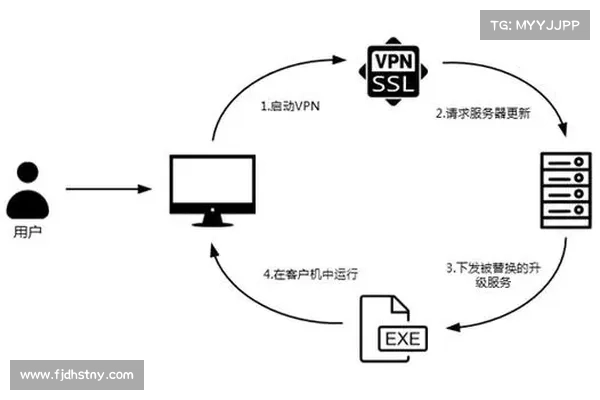

天行加速器付费版

天行加速器付费版LLM网络威胁预测的三种评分方式

“迅速和有效地检测云安全威胁的重要性不容小觑。我们坚信,利用生成性AI可以为安全团队带来巨大好处,然而并非所有的LLMs都是一视同仁的,”Skyhawk的AI及研究主管Amir Shachar说道。

Skyhawk的基准模型通过比较和评分公司机器学习模型提取和创建的攻击序列与数百个人工标记序列,使用了三种方式进行测试:精度、召回率和F1分数。根据Skyhawk的说法,得分越接近“1”,LLM的预测准确性就越高。结果可以在这里查看。

“由于必须保护客户和我们的技术机密,我们无法透露用于评分过程的具体标记流,”Shachar在接受CSO采访时表示。“总体而言,我们的结论是,LLMs在威胁检测中可以非常强大和有效,只要你智慧地使用它们。”

Shachar强调,企业要明白不能仅仅把数据[扔给LLM]而期望它们自动完成工作。“我们非常仔细地构建了我们的技术,通过从根本上利用正确的概念,将LLMs融入实时威胁检测中,现在我们利用这一点为更广泛的行业提供LLM性能的洞见,以增强安全社区。”

Skyhawk表示,其数据将定期更新,并可以通过其网站免费查看。